Ia, sfida per sicurezza energetica: entro 2030 raddoppia domanda elettricità. Aumentano emissioni

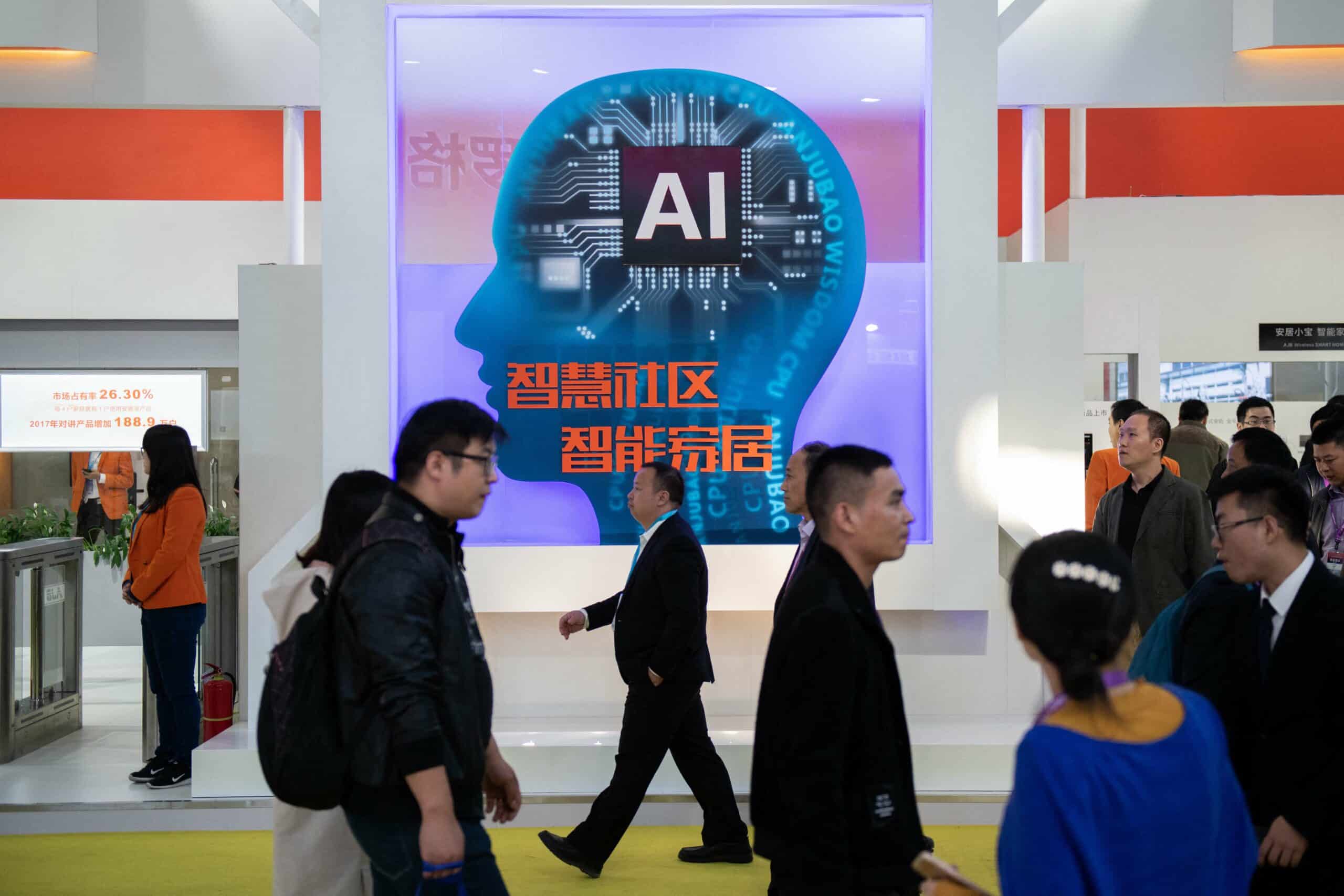

Photo credit: AFP

‘Dopato’ dall’intelligenza artificiale, il consumo di elettricità dei data center “più che raddoppierà” entro il 2030, rappresentando una sfida per la sicurezza energetica e un fattore di aumento delle emissioni di CO2.

Secondo un rapporto dell’Agenzia Internazionale per l’Energia (AIE) dal titolo ‘Energia e Ia’, pur essendo già ad alto consumo energetico, i data center hanno raddoppiato la loro capacità di elaborazione con il recente sviluppo dell’intelligenza artificiale generativa, che richiede capacità di calcolo colossali per elaborare le informazioni accumulate in database giganteschi. Nel 2024, queste infrastrutture rappresentavano solo circa l’1,5% del consumo globale di elettricità (415 TWh), ma negli ultimi cinque anni questa percentuale è già aumentata del 12% all’anno. E non è ancora finita.

Secondo l’Aie, “si prevede che la domanda globale di elettricità dei data center raddoppierà entro il 2030, raggiungendo circa 945 terawattora (TWh), ovvero una cifra leggermente superiore all’attuale consumo totale di elettricità del Giappone”. Entro questa data, i data center consumeranno poco meno del 3% dell’elettricità mondiale. A livello locale, “un centro elaborazione dati da 100 megawatt può consumare la stessa quantità di elettricità di 100.000 famiglie” all’anno, ma domani “i centri più grandi in costruzione oggi consumeranno 20 volte di più“, l’equivalente del consumo di 2 milioni di famiglie.

In un rapporto di 302 pagine, il primo dedicato all’intelligenza artificiale, l’agenzia per l’energia esamina “uno dei problemi energetici più urgenti e meno compresi oggi”. “L’intelligenza artificiale potrebbe trasformare il settore energetico nel prossimo decennio, incrementando la domanda di elettricità dai data center di tutto il mondo e offrendo al contempo significative opportunità di ridurre i costi, migliorare la competitività e tagliare le emissioni”, ha affermato l’Aie. I data center sono distribuiti in modo non uniforme nel mondo e concentrati in poche regioni all’interno di un Paese, spesso in prossimità delle città, il che solleva sfide in termini di fornitura e dimensionamento della rete elettrica. Questo aumento sarà “particolarmente” marcato in alcuni Paesi, come gli Stati Uniti, dove “i data center sono sulla buona strada per rappresentare quasi la metà” della domanda aggiuntiva di elettricità, sottolinea il direttore esecutivo dell’Agenzia Fatih Birol.

Insieme, Stati Uniti, Europa e Cina rappresentano oggi circa l’85% del consumo dei data center. La prima sfida è quindi quella di trovare elettricità a prezzi accessibili e in abbondanza. Nel tentativo di prendere le distanze dalla Cina nel campo dell’intelligenza artificiale (IA), il presidente degli Stati Uniti Donald Trump ha lanciato la creazione di un “Consiglio nazionale per il dominio energetico” con il compito di incrementare la produzione di energia elettrica. Secondo l’AIE, “per soddisfare le crescenti esigenze verrà utilizzata un’ampia gamma di fonti energetiche“, tra cui il carbone, che attualmente soddisfa il 30% del fabbisogno dei data center. “Tuttavia, si prevede che le energie rinnovabili e il gas naturale assumeranno un ruolo guida, grazie alla loro competitività in termini di costi e alla loro disponibilità nei mercati chiave“, si legge nel rapporto.

La corsa ai data center porterà inevitabilmente a un aumento delle emissioni legate al consumo di energia elettrica, dagli attuali 180 milioni di tonnellate di CO2 a 300 milioni di tonnellate entro il 2035, una quota minima però rispetto alla portata delle emissioni globali stimate nel 2024 (41,6 miliardi di tonnellate di CO2), avverte l’IEA. “Sebbene queste emissioni restino al di sotto dell’1,5% delle emissioni totali del settore energetico in questo periodo, i data center sono tra le fonti di emissioni in più rapida crescita“, aggiunge. Tuttavia, secondo l’Aie, queste emissioni aggiuntive potrebbero essere compensate o addirittura superate da potenziali risparmi di emissioni nel settore energetico e in altri settori, grazie ai guadagni di efficienza e alle innovazioni guidate dall’intelligenza artificiale. “I timori che l’intelligenza artificiale acceleri il cambiamento climatico sembrano esagerati, così come le aspettative che l’intelligenza artificiale da sola possa risolvere il problema“, conclude Aie. Con cautela, l’agenzia ritiene che “l’adozione dell’intelligenza artificiale non sia garantita e potrebbe essere compensata da effetti di rimbalzo e da un aumento del consumo di combustibili fossili“. In altre parole, l’intelligenza artificiale non è “una soluzione miracolosa” nella transizione energetica e resta necessaria una “politica proattiva”.